Multisearch: Ny søgefunktion gør det muligt at kombinere billeder og tekst

Google lancerer en ny AI-baseret søgefunktion til telefoner, hvor brugerne med tekst og billeder kan målrette søgninger af de objekter, de ser. Samtidig lanceres nye funktioner i korttjenesten Maps.

Googles søgemaskine får nu flere kræfter i form af funktionen Multisearch, som gør det muligt at finde information på en ny måde ved at kombinere visuelle og skriftlige søgninger. Funktionen ruller nu ud globalt – og dermed også på dansk.

Søgninger via telefonens kamera har længe vundet frem via Google-app’ens funktion Lens, hvor man nemt kan “søge, hvad man ser”. Det sker nu 10 milliarder gange om måneden. Eksempelvis hvis man vil afkode et vejskilt eller hunderace, oversætte en tekst eller dobbelttjekke den svamp, man overvejer at plukke. Det er denne funktion, som nu får et helt nyt lag med tilføjelsen af tekst.

Med Multisearch kan du tage et billede af en gul stol og derefter finde den samme eller en lignende stol i en anden farve ved fx at tilføje ordet “beige”. Forelsker du dig i et mønster på et tapet, kan du hurtigt finde fx tasker med lignende udtryk. Ellers tager du et billede af en plante, kan du få hjælp til at holde den i live ved at søge efter “hvordan passer jeg denne plante”.

Over de kommende måneder bliver Multisearch desuden udstyret med tilføjelsen Near Me, hvor du hurtigt kan finde en nærliggende butik, som forhandler det produkt, du tager et billede af. Ved at tage et billede af en kop kaffe og søg efter “i nærheden af mig” får du eksempelvis forslag til kaffebarer i området.

“Kunstig intelligens gennemsyrer allerede de fleste af Googles produkter, og det gælder ikke mindt de mest udbredte tjenester som Search og Maps, hvor det giver adgang til helt nye oplevelser. Med Multisearch kan brugerne søge på nye, kreative måder ved at kombinere det visuelle med tekst – og hurtigere finde netop dét svar, de leder efter,” siger Jesper Vangkilde, kommunikationschef for Google i Danmark.

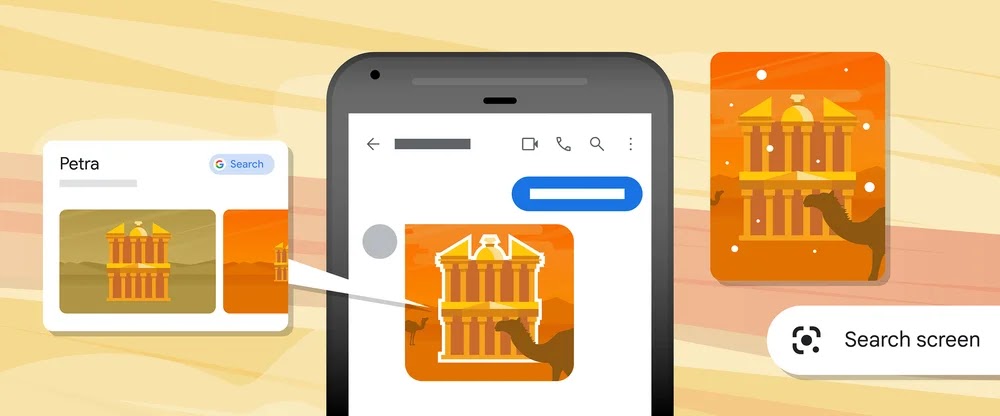

En tredje opdatering af Search er, at Android-ejere inden længe får en funktion, hvor de kan søge i billeder og videoer på tværs af hjemmesider og apps direkte i de pågældende apps. Det kræver blot et langt tryk på tænd-sluk- eller hjem-knappen.

Læs mere om de nye funktioner i Search